Technologies et savoir faire

Assistance à l’apprentissage de l’éco-conduite

Dans le cadre des travaux sur l’éco-conduite, le concept clé utilisé pour la conception d’assistance à l’apprentissage de l’écoconduite est le « serious gaming» ou «ludification». Ainsi, le conducteur, que ce soit avant, pendant ou après la conduite se retrouve impliqué dans un jeu qui vise à convertir son style de conduite. Un système d’objectifs, de récompenses, de conseil et de suivi personnalisé et géolocalisé est mis en place afin de maximiser l’acceptabilité et la durée de vie de l’application. Aussi, depuis 2012, COSYS travaille sur une plate-forme d’apprentissage ludique de l’éco-conduite en réalité virtuelle basée sur un banc de conduite, un casque de réalité virtuelle et le logiciel SiVIC. Outre l’aide au prototypage d’aides à la conduite et de capteurs pour le véhicule autonome, cette plate-forme vise à démontrer, lors d’événements à but de vulgarisation scientifique, les capacités de recherche et développement du laboratoire ainsi qu’à collecter des données de conducteur. Cette plate-forme a notamment été démontrée lors événements prestigieux tels que le mondial de l’auto à Paris en 2014 et le CES Las Vegas en 2017 en coopération avec la société ESI-Civitec.

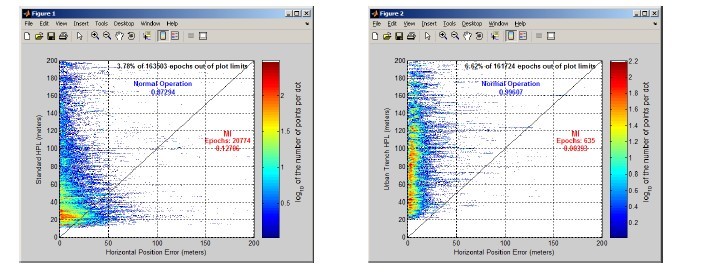

disponible : solution GPS standard (gauche), méthode des tranchées urbaines (droite)

bien plus pertinente car l’erreur est mieux bornée qu’en standard

Localisation

Outre les résultats issus des travaux de SmartWalk, on s’est attaché à l’amélioration de la précision et de l’intégrité du positionnement dans des environnements complexes comme l’urbain et le ferroviaire. L’idée directrice consiste à augmenter le signal GNSS d’une information issue de cartes 3D urbaines préexistantes ou de flux vidéos issus de caméras embarquées. L’étude INTURB (Urban Trench Method) pour la DGITM a suivi la 1ère approche. On a développé une méthode qui diminue améliore la précision du calcul de positionnement grâce à une modélisation 3D simple et compatible avec les cartes numériques embarquées d’aujourd’hui. La méthode mise en place sur des mesures réalisées à Paris et à Nantes a permis d’améliorer la précision de positionnement du véhicule de 70% en médiane en 3D. La validation de la méthode avec des mesures réalisées à Toulouse a abouti à une amélioration de 30%. On a aussi construit automatiquement la loi d’erreur de pseudo-distance des satellites en fonction des caractéristiques de l’environnement urbain et de la position du satellite par rapport à la rue. Cette recherche a débouché sur une amélioration de la précision et de l’intégrité du positionnement. Les expériences en vraie grandeur, réalisées à Nantes, Paris et Toulouse, pour une durée totale de 10 heures, permettent de garantir un risque d’intégrité de l’ordre de grandeur de 10−3 avec une confiance à 10%.

Assimilation rapide du transport des polluants dans l’air

Selon l’OMS, un décès sur 9 est attribuable à un défaut de qualité de l’air. Afin de mieux prévoir les expositions auxquelles sont soumises les individus, la distribution massive de cap- teurs bas coût associée à une modélisation fine de la ville constitue une voie privilégiée dans le programme scientifique de Sense-City. A cette fin, on a développé des outils numériques peu coûteux pour cartographier la concentration de polluants sur des quartiers entiers à partir de mesures et de modèles déterministes (EDP) qui permettent une quantification pré- cise à l’échelle des individus. La méthode de base réduite ”PBDW” a été adaptée et permet désormais de calculer en 1 sec, à l’aide d’une dizaine de capteurs, la concentration de pol- luants avec une erreur inférieure à 5% sur un quartier de 1km2 (figure ci dessous). Elle reconstruit des champs de polluants sans requérir à la reconstruction de l’aéraulique. Elle se montre prometteuse pour reconstruire en temps réel des champs de pollution à grande échelle.

Contrôle de la qualité de l’air dans les bâtiments

La qualité de l’air intérieur se dégrade avec l’amélioration de l’efficacité énergétique des bâtiments passant par la réduction de la ventilation, à tel point qu’il conviendra de la contrôler in situ dans le parc des bâtiments les plus efficaces. Or les personnes restent en moyenne 80% du temps en intérieur. Dans le cadre du projet IMMANENT et de Sense-City, on a codirigé la thèse de W. César avec D. Angelescu (ESIEE-Paris) sur le développement de micro- chromatographes destinés à détecter simultanément un grand nombre de composés gazeux dans les bâtiments. Le capteur fonctionne en temps réel et on a développé conjointement des méthodes numériques inverses de diffusion-transport pour cartographier les champs de concentration des composés gazeux et identifier les sources dans l’optique d’une gestion ad hoc des espaces intérieurs. Par ailleurs, le projet MIMESYS a permis d’étendre à l’air la stratégie de placement de capteurs développée pour les réseaux d’eau.

Estimation de la tension dans les câbles

On a mis au point une méthodologie très innovante pour déterminer la tension des câbles d’ouvrages, via la détermination des caractéristiques de tension axiale, de masse linéique et de longueur. Elle mobilise capteurs bas coût, modèle de câble géométriquement exact et méthode inverse originale exploitant la différence de données de mesure entre deux configurations statiques différentes (thèse Arnaud Pacitti). Elle a été validée sur le nouveau banc des câbles du CEREMA à Bordeaux conçu par COSYS et sur un ouvrage sur la Loire.

La calibration une fois réalisée réduit nettement l’incertitude inhérente aux méthodes classiques dont on étend ainsi le domaine d’emploi.

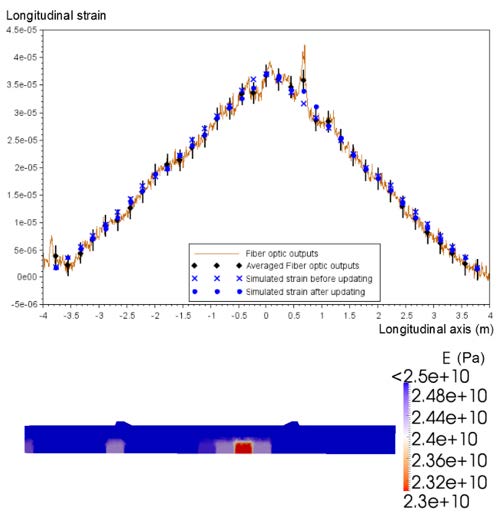

dans la poutre (fissure détectée à x=0,7m) et déformation simulée

(en bleu) ; Bas : module d’Young après recalage, localisation

et quantification d’un endommagement (zone rouge)

Détection-quantification d’endommagements dans des poutres précontraintes

En vue de la détection précoce d’un endommagement structural par des méthodes in- verses on cherche en général à déterminer les paramètres du modèle caractéristiques de l’endommagement, i.e. le module d’Young, afin de minimiser l’écart entre les mesures et la déformation issue de la simulation numérique, ici fondée sur l’élasticité plane. Dans le cadre du projet SIPRIS avec VINCI, on s’est intéressé aux mesures locales de déformation par fibre optique ou par jauges ponctuelles pour l’identification des paramètres du modèle par méthode adjointe. Cette stratégie a été implantée de façon non-intrusive à l’aide d’un superviseur en langage Python faisant appel au code de calcul Aster. Sur une poutre en béton précontraint de 8m de long, les méthodes inverses ont permis de détecter, de localiser et de quantifier un endommagement (zone rouge sur la Figure ci-dessous).

Détection d’affouillements

Les affouillements constituent par ailleurs une cause majeure d’effondrement ou de rupture de service des ponts. Dans le cadre du même projet SIPRIS, on a développé une modélisation directe et inverse de ponts soumis à des affouillements en vue de détecter automatiquement, en ligne, des seuils de stabilité des ouvrages en fonction de l’état réel des fondations. A cette fin, on a proposé et breveté avec VINCI un procédé alliant capteurs et modélisation inverse. L’innovation consiste à identifier le comportement intrinsèque et global des fondations de la structure sur la base de mesures cinématiques et d’une analyse de perturbation spectrale, sans avoir à mesurer, sous l’eau, la hauteur d’affouillement.

Identification de systèmes stochastiques et surveillance de l’endommagement

La création de l’équipe I4S a permis d’innover dans le domaine des algorithmes, avec un impact réel dans les applications industrielles. Les travaux conduits sur la quantification de l’incertitude (meilleur papier innovant à la conférence IOMAC en 2017) et l’identification de systèmes complexes (variables dans le temps ou périodiques : cas des éoliennes) ont été poursuivis en raison de leur pertinence industrielle et de leur capacité à fertiliser d’autres thématiques de recherche. Pourtant, le nombre croissant de capteurs différents sans parler de l’importance croissante des mesures distribuées par fibre optique et des mesures plein champ par technique d’imagerie pose un défi considérable aux méthodes que nous étudions. Pour y faire face, l’étude d’algorithmes adaptatifs tels que le filtre de Kalman et les filtres particulaires est un sujet émergent dont l’importance ne peut que croître avec des thèmes connexes comme le monitoring thermique long terme par thermographie infrarouge ou «Ultra Time Domain Thermography». Nous cherchons constamment à monter en complexité au niveau des structures surveillées tout en diminuant et optimisant le coût algorithmique et l’efficacité énergétique de nos solutions. Une illustration de nos avancées algorithmiques se retrouve dans le transfert de nos méthodes SSI, tant sur carte PEGASE en version embarquée pour preuve de concept all-in-one, que dans une optique de transfert comme chez nos partenaires «Structural Vibration Solutions - Denmark» : 3 transferts technologiques durant la période. Notre originalité au sein de la communauté du génie civil et mécanique est l’évaluation statistique des distances ”Model-to-Data” pour en déduire des changements structurels, comme peu d’équipes le font en Europe (par ex. Verhaegen, en Hollande). Au cours de la période actuelle, nous avons obtenu des résultats importants sur la caractérisation des changements d’origine physique et la robustesse au bruit, en collaboration régionale (GEM à Nantes) et internationale (U. de British Columbia à Vancouver et Boston Université). La localisation des endommagements est encore un sujet émergent. Des efforts sur l’applicabilité et la robustesse restent à fournir mais notre nomination pour le meilleur article théorique à SAFEPROCESS2015 montre le caractère prometteur de notre approche théorique ainsi que le chemin qui reste à parcourir avant une application sur des structures réelles.

Diagnostic de défauts fondé sur la réflectométrie

La principale originalité de nos contributions aux techniques fondées sur la réflectométrie est l’utilisation de la théorie de la diffusion inverse issue de la physique mathématique. Dans le domaine du diagnostic de défaut de câble électrique, les études fondées sur des modèles mathématiques résolvent principalement des problèmes inverses avec des méthodes d’optimisation non convexes coûteuses en temps et en ressources. Nos algorithmes évitent de résoudre les problèmes d’optimisation non convexes et sont numériquement efficaces pour les applications en temps réel. Notre logiciel déposé ISTL a commencé à être utilisé par des partenaires industriels. Ces résultats fournissent des solutions efficaces pour le diagnostic des défauts correspondant aux variations d’impédance ou aux pertes ohmiques dans les câbles.

Eoliennes

Le monitoring des éoliennes a fait l’objet de nombreux contrats. On retient ici le projet EVEREST sur les futures très grandes pales d’éoliennes off-shore. Un démonstrateur doté de plusieurs types de capteurs (fibres optiques, capteurs ultrasoniques, QRS issus de l’IRDL) en vue des essais de fatigue a permis de comprendre finement l’interaction capteurs-renforcements- structure et de préparer des solutions techniques industrialisables. Combinant essais de fatigue et modèle éléments finis, on a trouvé un positionnement de la fibre optique qui lui permet de délivrer la déformation moyenne exacte. V. Raman a globalement prouvé la faisabilité d’une pale alliant fibre de carbone, renforcements locaux et monitoring par capteurs intégrés garantissant un fonctionnement sécurisé.

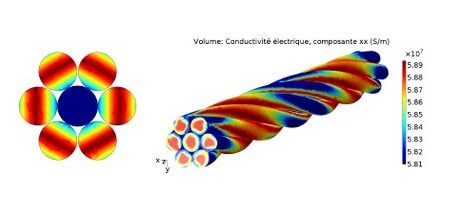

Câbles THT pour les fermes éoliennes

Avec NEXANS et RTE le projet EMODI qui s’inscrit dans le Domaine stratégique « Energies Marines Renouvelables » contribue à lever des verrous identifiés dans la feuille de route des EMR, tels que le raccordement des parcs EMR qui figure parmi les priorités européennes. On a créé un banc de fatigue dédié aux câbles sous tension, instrumentés par fibre optique et par nano-composites conducteurs. Les capteurs insérés à cœur servent à caler une modélisation analytique qui, à terme, permettra l’inspection avant mise en mer des câbles, sur la base d’une compréhension fine des couplages électro-thermo-mécaniques, un endommagement mécanique créant des singularités thermiques et de conductivité (figure b). Le but est ainsi de localiser et de juger du caractère pénalisant des défauts préalablement à l’installation très onéreuse de ces structures, un défaut sans danger pour la santé structurelle du câble pouvant dégrader de façon très significative la capacité de ce câble à transmettre la puissance électrique.

Trafic routier assimilé

Les gestionnaires de réseaux routiers ont besoin d’outils d’aide à la décision qui leur permettent d’anticiper les situations critiques et, lorsqu’elles se manifestent, d’être réactif et prendre les mesures les plus appropriées. Les méthodes d’assimilation de données répondent à cette attente. Elles consistent à utiliser un modèle dynamique de trafic et à le mettre continûment à jour en fonction de données recueillies dont dispose l’exploitant. Ainsi, le gestionnaire peut à la fois disposer d’une vue complète sur les conditions de trafic actuelles sur le réseau, et tester l’impact de stratégies d’exploitations à très court terme (<1h).

Depuis 2014, des travaux de recherche sur l’assimilation de données ont été entrepris pour s’adresser à des réseaux routiers structurants (nationale ou autoroute) à large échelle (plusieurs centaines de kilomètres de linéaire).

Plusieurs verrous scientifiques ont été identifiés et levés au cours de ces dernières années : Le modèle dynamique du premier ordre (LWR) résolu sur un schéma numérique méso- scopique, dispose de propriétés très adaptées : temps de calcul réduit, schéma numérique très adapté aux observations Eulériennes et Lagrangiennes classique dans le trafic routier. Il convient par ailleurs d’estimer les incertitudes liées aux mesures sur le terrain ou au modèle de trafic et de les prendre en compte dans le schéma d’assimilation de données. Un modèle de propagation d’incertitude a été proposé. Enfin, on a proposé une méthode d’optimisation pour déployer les capteurs de trafic sur le réseau de manière optimale en vue de l’assimilation de données.

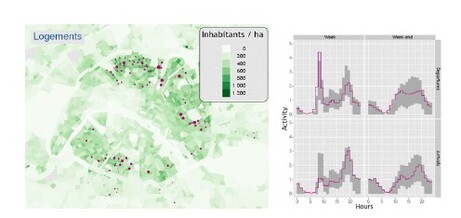

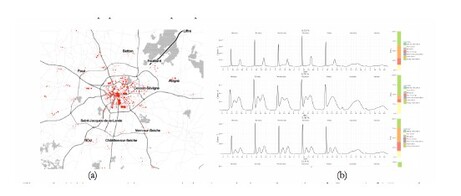

Traces numériques et analyse de la mobilité

Dans le domaine de la mobilité, les data permettent de mieux comprendre les pratiques de mobilité et la manière dont elles s’articulent avec les territoires. La mise à disposition des données massives urbaines pose une question essentielle : Quels apports de connaissance sur nos mobilités et nos villes ces nouvelles données offrent-elles ? Et dans quelle mesure ces données peuvent-elles compléter les enquêtes classiques ? Cette problématique a été abordée à travers deux études : les données billettiques des transports collectifs de la ville de Rennes (Projet Mobilletic, figure a) et les données d’usage de systèmes de vélos en libre-service en partenariat avec JC Decaux et la Mairie de Paris (figure b).

Les travaux fondés principalement sur des méthodes d’apprentissage non-supervisé de type modèles de mélange à variables latentes ont débouché sur des modèles innovants.

Nous avons pu mettre en évidence, grâce au croisement des résultats de clustering avec les données socio-économiques des territoires sur lesquels les systèmes de transport sont déployés, les liens forts entre profil d’usage des stations et caractéristiques urbaines du voisinage de la station.

L’analyse des matrices Origine/Destination dynamiques dérivées des données de déplacement a permis de caractériser la dynamique des systèmes de transport afin d’aider à leur optimisation. Nous avons exploré dans ce cadre les modèles génératifs à variables latentes et les « topic models», initialement utilisés pour la fouille de texte. Une extension de ces modèles pour l’aide au dimensionnement et au positionnement des stations VLS a été proposée. L’extraction de routines temporelles d’usagers de transport urbain collectif (TC) à partir de données billettiques (ou données smartcard) a débouché sur un modèle génératif à deux niveaux de clustering permettant de fournir à la fois le partitionnement des usagers en groupes et une description fine du comportement de chaque groupe d’usagers à l’aide d’un profil continu en temps a été proposé. Ce travail a fait l’objet de collaboration avec l’école polytechnique de Montréal au Québec. Ces données permettent en effet de mettre en évidence des comportements de mobilité variables dans les transports en commun (selon les jours de la semaine et selon l’heure de la journée par exemple) et de s’affranchir de la vision jour moyen de mobilité qu’autorisent les enquêtes classiques. Les routines temporelles ainsi identifiées caractérisent finement la demande, et peuvent servir d’entrées aux modèles de simulation ; elles peuvent également être utilisées par les gestionnaires urbains et les opérateurs de transport pour des opérations de planification en vue d’adapter l’offre de transport à la demande. Cette connaissance fine de la demande dans l’espace et dans le temps peut être mise à profit pour offrir des services de mobilité à la demande.

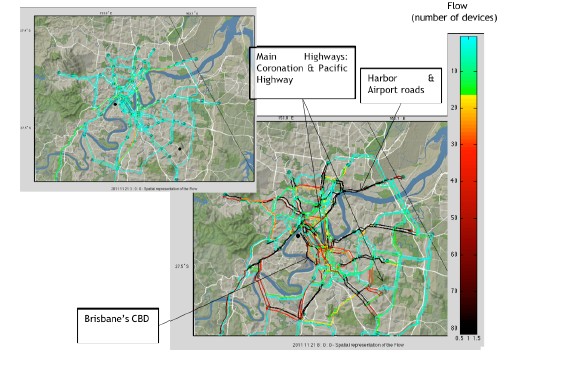

L’exploitation innovante des données issues de dispositifs Bluetooth pour la gestion du trafic constitue un sujet original. Nos contributions portent sur la qualification et le traite- ment des données Bluetooth pour cartographier les états de trafic à l’échelle d’un réseau puis sur l’analyse spatio-temporelle des états des réseaux. La méthode dite «Latent Dirichlet allocation - LDA)», a permis de détecter des motifs temporels de fonctionnement du réseau.

L’utilisation des données Bluetooth pour l’estimation dynamique de matrice OD (figure c) a également donné lieu à une thèse qui a obtenu le double prix Abertis du meilleur Master et de la meilleure thèse au niveau international.

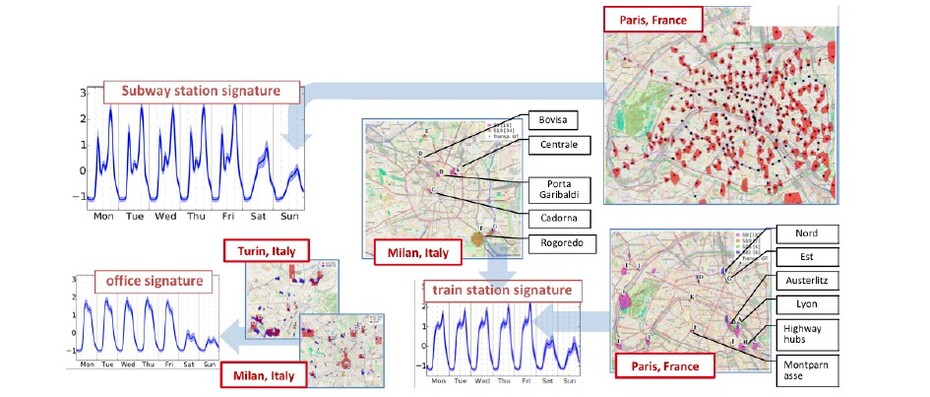

Caractérisation des fonctions urbaines

La caractérisation automatique et spatio-temporelle des fonctions urbaines au travers des données massives représente l’autre sujet important sur lequel on s’est mobilisé pour la gestion des villes intelligentes. Des travaux antérieurs sur des données de téléphonie mobile ont montré l’existence de fortes corrélations entre les propriétés du tissu urbain et la de- mande de communication mobile associée. De même, les traces GPS des véhicules flottants contiennent des informations importantes sur la demande de transport et sur les activités humaines qui peuvent être liées aux fonctions urbaines.

La caractérisation des fonctions urbaines qui émergent utilisent ici, conjointement, des traces GPS des véhicules sondes et des données de téléphonie mobile collectées par les fournisseurs de réseau (figure ci dessous).

Ces travaux sont fondés sur des techniques d’apprentissage non supervisé pour identifier les différentes classes de signatures (séries temporelles associés au trafic de téléphonie mo- bile et aux données GPS) caractéristiques de différentes fonctions urbaines. Ces techniques ont exploité les données réelles collectées dans des villes françaises et italiennes. Les résultats dévoilent l’existence de signatures communes aux zones étudiées et spécifiques à certaines fonctions socio-économiques.

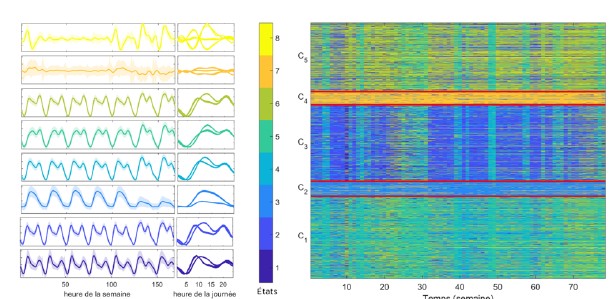

Réseaux urbains intelligents d’eau et d’électricité

L’émergence des réseaux intelligents permet la remontée d’un grand nombre de données dont l’exploitation croisée aidera à la création de services à valeur ajoutée pour le collectif. Ces données aident à mieux connaitre les habitudes de consommation et à les prévoir de façon précise. Elles aident aussi à détecter des anomalies au niveau des infrastructures. Pour cela, on dispose de données massives, spatiales et temporelles. On a développé des techniques adaptées d’analyse des masses de données produites pour mieux comprendre l’usage des systèmes et identifier des motifs spatio-temporels en vue ensuite de mettre au point des outils de prévision et de gestion intelligente.

Nos propositions s’appuient sur deux projets : l’un en partenariat avec VEOLIA et le Syndicat des Eaux D’Ile de France, et l’autre (projet Smart City Energy) coordonné par SystemX. Nos modèles et algorithmes permettent d’agréger de longues séries temporelles périodiques sur l’usage de l’eau et l’électricité. On obtient une représentation simplifiée des masses de données initiales, avec un pouvoir prédictif. Une optimisation stochastique a per- mis la classification en ligne de séries temporelles massives par estimation des paramètres. Grâce à des modèles markoviens à variables latentes tenant compte du contexte (calendaire, météorologique) on peut prévoir les habitudes de consommation à l’échelle d’un réseau (ville, quartier)